Representación de la información mediante patrones de bits

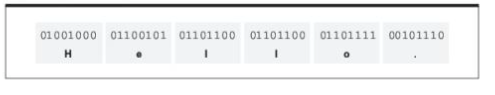

Representación de texto

La información en forma de texto se suele representar por medio de un código en el que se asigna un patrón determinado de bits a cada uno de los distintos símbolos que aparecen en el texto. El texto se representa entonces mediante una larga cadena de bits, en la que los sucesivos patrones representan los símbolos sucesivos del texto original.

El instituto ANSI (American National Standards Institute) adoptó el código ASCII (American Standard Code for Information Interchange). (patrón de 7 bits + 0 en el más significativo)

Se desarrollo el código de Unicode mediante la cooperación de varios de los principales fabricantes de hardware y software; dicho código ha obtenido rápidamente el respaldo del sector informático. Este código utiliza un patrón distintivo de 16 bits para representar cada símbolo.

El mensaje "Hello" en ASCII

Un archivo compuesto por una larga secuencia de símbolos codificados mediante ASCII o Unicode suele denominarse archivo de texto. Un archivo de texto contiene únicamente una codificación carácter a carácter del texto, mientras que un archivo generado por un procesador de texto contiene numerosos códigos propietarios que representan cambios en los tipos de fuente, información acerca de la alineación, etc.

Representación de valores numéricos

Utilizando notación binaria podemos almacenar cualquier entero comprendido dentro del rango que va de 0 a 65535 en esos 16 bits. Por lo tanto la notación binaria se emplea ampliamente para codificar los datos numéricos de cara a almacenarlos en una computadora.

Comúnmente se emplea un sistema conocido como notación en complemento a dos para almacenar número enteros, porque proporciona un método como de representación de números tanto negativos como positivos. Para representar números con parte fraccionaria, como 4 1/2 o 3/4 se emplea otra técnica conocida como notación en punto (coma) flotante.

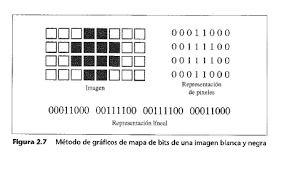

Representación de imágenes

Un método para representar una imagen consiste en interpretar dicha imagen como una colección de puntos, cada uno de los cuales se denomina pixel, abreviatura de la expresión inglesa "picture element". A continuación de codifica la apariencia de cada pixel y la imagen completa se representa como una colección de píxeles codificados. A este tipo de colección se le conoce como mapa de bits.

En el caso de imágenes en color, cada pixel se codifica mediante un sistema con dos enfoques bastante comunes. En uno de ellos, que denominaremos codificación RGB, cada pixel se representa mediante 3 componentes de color: rojo, verde y azul, lo que corresponde con los 3 colores primarios de la luz. Para representar la intensidad de cada componente de color normalmente se usa un byte. En consecuencia, hacen falta 3 bytes de almacenamiento para representar un único pixel de la imagen original.

Una alternativa de RGB consiste en utilizar un componente de "brillo" y dos componentes de color.

La forma geométrica de representar las imágenes es muy popular en los sistemas de diseño asistido por computadora (CAD, Computer-aided design), en los que se visualizan y manipulan en las pantallas de computadora dibujos de objetos tridimensionales.

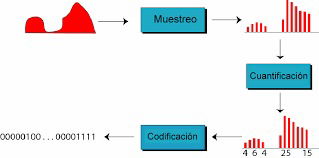

Representación de sonidos

El método más genéricos de codificar información de audio para su almacenamiento y manipulación en una computadora consiste en muestrear la amplitud de la onda de sonido a intervalos regulares y grabar la serie de valores obtenidos. Esta técnica, empleando una tasa de muestreo de 8000 muestras por segundo.

Aunque 8000 muestras por segundos puede parecer una tasa muy rápida, no resulta suficiente para la grabación de música en alta fidelidad. Para obtener una reproducción de sonido de calidad comparable a la que puede obtenerse con CD musicales de hoy en día, se utiliza una tasa de muestreo de 44.100 muestras por segundo. Los datos obtenidos para cada muestra se presentan mediante 16 bits. En consecuencia, cada segundo de música almacenado en estéreo requiere más de un millón de bits.